MÉTODO CIENTÍFICO, ASPECTOS EPISTEMOLÓGICO Y METODOLÓGICOS PARA EL USO DE LA ESTADÍSTICA

Ignacio Méndez Ramírez*

Instituto de Investigaciones en Matemáticas Aplicadas y en Sistemas Universidad Nacional Autónoma de México.

Resumen. En todo trabajo de Investigación, se tiene un marco epistémico. En muchas áreas de investigación “tradicionales” como la Biología, Medicina, Agronomía, etc., este marco es tácito, es decir se asume inconscientemente. Además es muy común que sea un marco totalmente erróneo, a partir de la filosofía del Positivismo o Empirismo Lógico. El uso de este marco hace que la investigación sea muy rígida, pretendiendo ser totalmente objetiva y racional. Los filósofos modernos han rechazado unánimemente este marco epistémico, y han postulado entre otras cosas, que la ciencia no es totalmente objetiva, que hay actos en el proceso de investigación científica, que no pueden ser justificados totalmente de forma racional. En el artículo, se discuten brevemente estos aspectos epistemológicos.

Se introduce también algunas ideas sencillas sobre conceptos de causalidad y de aspectos metodológicos para apoyar la causalidad, en particular la eliminación o minimización de los llamados factores de confusión, mediante cuatro procedimientos: la homogeneización de los elementos de estudio; la aleatorización de variantes de factores causales a los elementos; la formación de bloques o estratos homogéneos dentro de ellos pero heterogéneos entre ellos y mediante la formulación de modelos estadísticos que contemplen las acciones simultáneas de varios factores.

palabras clave: Objetividad; Metodología; Estadística; Población; Epistemología

Abstract. Any research work supports its own epistemic frame or support. In applied research areas such as Biology, Agronomy, Medicine and others, that frame is assumed in a tacit way. Usually, it is erroneously supported either in positivistic philosophy or logic empiricism. The use of such frame renders research inflexible, even if pretending to be objective and rational. Modern philosophers unanimously reject such philosophic frame. They consider that research is not totally objective, that there are terms of the research that cannot be totally justified in a rational and objective way. In this article a short discussion on these epistemic topics is presented.

Both, the concept of causality and methodological considerations are introduced in order to study relationships postulated as causal; particularly, the elimination of alternative explanations, such as the confusion factors. Research was driven within four methodological procedures: homogenization of the study units, random allocation of the variants that represent the proposed causes, blocking of groups of units, and the use of statistical models, such as covariance analysis that consider the simultaneous occurrence of several explicative factors.

Key Words: Objectivity; Methodology; Statistics; Population; Epistemology

Original recibido el 03-08-2012

Última revisión el 06-09-2011

1.Justificación

La estadística se utiliza con frecuencia creciente como una parte de la metodología de investigación, tanto en la fase de planeación (protocolos) de la investigación como en la interpretación y análisis de la información obtenida en ella.

Es importante que tanto los estadísticos como los investigadores en áreas sustantivas (ciencias fácticas), tengan una base de ideas y conceptos comunes para poder integrar los grupos interdisciplinarios necesarios para el buen éxito de las investigaciones.

Una fuente de problemas en la planeación de investigaciones, en el análisis estadístico y en la interpretación de ellas, surge por un marco filosófico o epistemológico inadecuado. Es frecuente la concepción mágica de que la estadística puede validar una investigación o bien que prueba sin lugar a dudas la veracidad de una hipótesis. También la idea de que existe un método científico infalible y obligado, entonces basta con seguirlo y no habrá errores, además de que la estadística con reglas rígidas (alfa de 0,05, n = 4, etc.), es parte de ese método.

Los filósofos de la ciencia modernos, consideran que no hay un método científico infalible y obligado, que hay cierta subjetividad en la investigación (lo que no significa hacer trampas). También que la estadística sólo es un valioso auxiliar en la planeación y análisis, pero que como toda conceptualización humana, esta sujeta a aspectos falibles.

En virtud de lo anterior es necesario que se estudie la filosofía de la ciencia moderna, así como aspectos de metodología general y los fundamentos epistemológicos de la estadística misma, para valorar adecuadamente el papel de la estadística en la investigación. Revisar los conceptos de: Concepto, teoría, objetividad, empirísmo, racionalidad, modelaje matemático, entre otros. Valorar otras características de la investigación científica. Critica a la visión positivista de la ciencia. Evaluar el concepto de Causalidad y las dificultades para su valoración Se ha avanzado en la postulación de una posición llamada de “falsacionismo metodológico” en la que se ubica con claridad el papel de la aleatorización, formación de bloques y pruebas de significancia estadística.

2.Aspectos epistemológicos

Por considerar que la posición filosófica de los practicantes de alguna ciencia, afecta de manera muy importante los supuestos que se hacen al investigar y en ocasiones también a los aspectos metodológicos, es necesario revisar aun que sea someramente algunos aspectos de la filosofía de la ciencia. Se plantea de modo esquemático una comparación de posiciones epistémicas. Se mencionan sólo algunas de las características más relevantes. Además éstas están relacionadas unas con otras.

3.Objetividad, Empirismo

A partir del renacimiento y durante la Ilustración, culminando con Descartes, se considera la existencia de una realidad objetiva totalmente comprensible por la mente humana, al mismo tiempo que esa mente esta separada y no contaminada por la realidad. De aquí se desprende una recomendación a los investigadores. “Para hacer ciencia hay que ser totalmente objetivo”, o bien “En la construcción de teorías, sólo la información empírica es la que cuenta”. Se ha reconocido ya por muchos pensadores que no se puede ser totalmente objetivo y que para construir teorías se utiliza tanto la información empírica como las ideas y teorías previas que se tienen, se puede decir “los hechos tienen carga teórica”. El conocimiento se construye a partir de ideas previas y experiencias empíricas. Hay una indivisibilidad del conocimiento, con el método usado para adquirirlo y con los supuestos teóricos empleados. Esto se expresa de manera esquemática en la figura

Como un ejemplo de la relación objetividad y metodología, he planteado a muchos alumnos a los que les solicito que se responda falso o verdadero, a la siguiente aseveración, “Las estaturas de los seres humanos tienen distribución normal”, la respuesta con cierta frecuencia es que es verdadero. La consideración de verdadera en esta aseveración, tiene implicaciones epistémicas y metodológicas. En el aspecto de la epistemología, esto implica que la distribución normal es una propiedad objetiva de la naturaleza de los conjuntos de seres humanos. Como si la distribución normal fuera algo que existe en la naturaleza y que sólo hay que ”descubrirla”. Al señalar que sobre la base de consideraciones del modelo matemático, en toda distribución normal, no importan los valores de la media y la desviación estándar, la probabilidad de un valor negativo es mayor que cero; P(x < 0) >0. Si esto se refiere a las estaturas de los seres humanos, implicaría la existencia de seres humanos con estatura negativa (¿?). Los alumnos al señalarles esto ya dudan de la veracidad de la aseveración. Mi consideración es que la normal como un modelo matemático no es una propiedad objetiva de la naturaleza en ningún caso. Se podrá decir, en ciertos casos, que el modelo normal describe con una aproximación aceptable la distribución de frecuencias de las estaturas dentro de algún grupo de seres humanos relativamente homogéneo. El ejemplo además, tiene una implicación metodológica que conduce a un error de diseño grave, consiste en el hecho de que no se especificó, a que grupo de seres humanos se les aplicaría la distribución normal. Ciertamente, si se toman niños recién nacidos junto con adultos algunos de sexo masculino y otros del sexo femenino y además de diferentes grupos raciales; entonces el modelo de la distribución normal es absolutamente inadecuado. Quizá para un grupo de seres humanos homogéneos en edad, sexo, grupo racial y tipo de alimentación, el modelo normal pueda ser una buena aproximación para la distribución de las estaturas. Este ejemplo es bastante representativo de la necesidad de consideraciones epistémicas en todo el uso de la estadística. Así este error, desgraciadamente muy frecuente, conduce de modo general a tomar una variable numérica medida en un tipo de entidades y sin mas consideraciones, asumir (considerar válido) un modelo probabilístico para la variabilidad de esas mediciones. Otra implicación metodológica es la búsqueda de modelos que se ajusten o representen la realidad prácticamente sin error, lo cual en estadística es imposible.

Esta situación sobre el carácter ontológico de la matemática, como una propiedad objetiva (tipo platónico), tiene otras consecuencias para la investigación, sólo comento algunas.

Produce un exceso de confianza en la matemática, incluso en ocasiones con un papel validador de teorías y conocimientos. Así, se considera “si se expresa matemáticamente no puede estar equivocado”; en particular en estadística, “Si hay diferencias estadísticamente significativas, se demuestra una hipótesis científica”

Rechazo a las ciencias sociales, por que no usan matemática.

Evitar consideraciones o argumentos teóricos, si no están ligados a las definiciones en expresiones matemáticas.

Ignorar el papel del diseño de investigación. Es decir no importa cómo se eligen los elementos de estudio o cómo se miden las variables. Se expresa “el modelo matemático describe la realidad”. A mí me parece más correcto decir “El modelo matemático representa con errores aceptables la realidad y esto lo hace mediado por el diseño de investigación”

4.Racionalidad en el Método

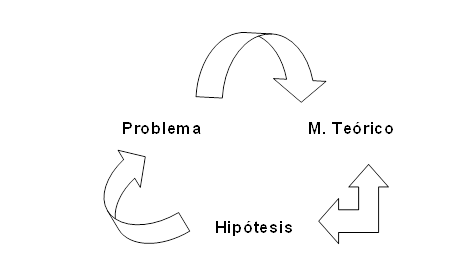

Por un marco epistémico inadecuado, es frecuente que se suponga la existencia de “Un método científico infalible y obligado”. Un método, en el sentido de que solo hay un camino para obtener conocimiento. Infalible por que si se siguen sus pasos se llega sin error a un conocimiento científico. Finalmente obligado por que para hacer ciencia hay que seguir ese método. Esto equivale a considerar que el método es racional. Por supuesto que muchos investigadores y prácticamente todos los filósofos rechazan esta posición. Sin embargo en la practica, hay aún investigadores quienes, aunque sea implícito, si trabajan según este supuesto. En particular esta situación produce una falta de crítica a los métodos y diseños de investigación usados, frecuentemente se copian diseños y metodologías sin una cuidadosa adecuación a la situación particular de cada investigador. Las consecuencias también se extienden al uso de los modelos matemáticos, los que también frecuentemente se utilizan sin considerar su pertinencia a cada situación particular. Para evitar este concepto erróneo de “método científico”, planteo dos ciclos en la fase de planeación de una investigación fáctica. Un primer ciclo: Problema – Marco Teórico – Hipótesis

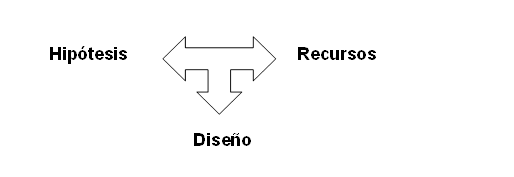

Un segundo ciclo es el de Hipótesis - Recursos – Diseño

Se entiende por diseño todo lo que se realiza empíricamente para obtener información que apoye o contradiga la hipótesis. Por supuesto que en este proceso de los dos ciclos, ligados por la hipótesis, se pasa de uno al otro, lo que busca es que exista la máxima coherencia entre los diversos componentes, pero no esta determinada una cosa en función de las demás, hay creatividad, pero también subjetividad. Se debe efectuar una crítica muy fuerte para que se logre plantear un diseño que sea factible con los recursos y que minimice las posibilidades y magnitudes de los errores, en la adquisición del conocimiento que representa contestar el problema vía el apoyo o no de la hipótesis. Se puede decir que no hay una racionalidad absoluta, en la elección del tema (problema), de la teoría pertinente, de la hipótesis y del diseño.

5.Reduccionismo o enfoque sistémico

Se ha comentado este aspecto en muy diversas fuentes, en las que se plantea de modo preponderante que no se puede entender un aspecto de la realidad, sólo estudiando cada una de sus partes por separado, se requiere un estudio de las interrelaciones de unas con otras, y que el todo tendrá propiedades que no son explicables o deducibles a partir de las propiedades de las partes. A esto le han llamado “propiedades emergentes”. Considero que estas ideas también son aplicables a la metodología, en el sentido de que unas partes de ella tienen relación y se afectan por otras. Para el empleo de la estadística esto, trae como consecuencia que no sea adecuado que los aspectos de la aleatoriedad del mundo y sus formas de representación (estadística), se contemplen de manera separada de los aspectos sustantivos o fácticos del problema estudiado. Lo que a su vez implica que las consideraciones estadísticas deben contemplarse en todas las fases de la investigación. Debido tal vez a la preponderancia del enfoque positivista, es frecuente que se plantee el uso de la estadística como una manera final de considerar la información y tratar de reducir la incertidumbre que la aleatoriedad o variabilidad que presentan los fenómenos estudiados. Esto trae como consecuencia que frecuentemente se ignora el diseño en la construcción de los modelos y del papel que el diseño puede tener para eliminar errores en general.

6.Causalidad

El concepto de causalidad ha sido muy discutido desde tiempos remotos, tomare aquí la visión de (Johnson, 1999)

Los conceptos de causa, eventos y todas las otras estructuras ligadas a eventos no son únicamente reflejos de una mente independiente de la realidad; son fundamentalmente conceptos humanos. Surgen de la biología del humano. Sus significados literales son muy pobres, en cambio son metafóricos de manera significativa e inevitable.

Los conceptos de causas y eventos no son objetivos en el sentido de estar en el mundo independientemente de la mente. Tampoco son puramente subjetivos en el sentido de estar en la mente, en forma contingente y radicalmente relativa. Se requiere un enfoque experimental para ellos.

Los conceptos de causas que han prevalecido son: Son substancias materiales, son formas, son propósitos, son la aplicación de una fuerza, son condiciones necesarias, son temporalmente a priori a los efectos, son leyes de la naturaleza, son uniformidades de la naturaleza, son correlaciones es decir relaciones constantes.

Se considera así, que muchos conceptos, entre ellos los de la causalidad surgen de metáforas entre las sensaciones y experiencias personales básicas con los objetos y sus relaciones en el mundo.

Por otro lado, si el estado resultante no ocurre siempre, se debe considerar a la causalidad en términos estadísticos, lo cual nos lleva al concepto de probabilidad. La causalidad probabilistica, especifica cambios en las distribuciones de los estados resultantes, al variar la especificación de los estados

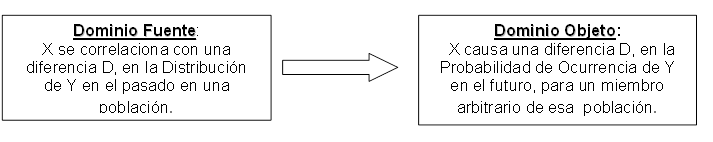

El uso adecuado de la estadística es la búsqueda de correlaciones que no puedan ser debidas a otros factores (correlación condicionada con los factores más factibles de explicar de modo alternativo, la asociación). Además hacer uso de otras teorías (con sus metáforas), para que la causalidad no se apoye nada más en las Metáforas “Correlación es Causalidad” y “Causalidad Probabílistica”.

7.Contrastación de hipótesis de Causalidad Estadística.

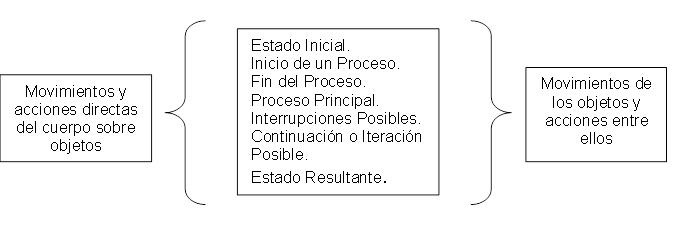

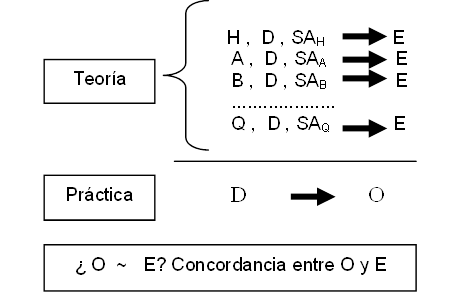

Como una manera de plantear de manera más clara cual es el papel del diseño estadístico y los análisis estadísticos en la búsqueda de apoyo empírico a una hipótesis de causalidad probabilística, se tiene el siguiente esquema. Sea D el diseño de investigación, es decir todas las operaciones empíricas que se efectúan para obtener información que apoye o entre en contradicción con la hipótesis. En este diseño D, resaltan aspectos como: definición de los elementos de estudio, y la población de interés, formas de obtener muestras representativas de la población, ¿qué se mide en los elementos, como se mide, cuando se mide con que instrumentos?, Etc. H es la hipótesis que establece que X es un factor causal o estado inicial, y de Y como efecto o estado resultante. Esto se va a representar esquemáticamente como

H -> X Y

Además se consideran algunos SA, supuestos adicionales de operación del mundo, teorías y otras explicaciones aceptadas. Entonces el silogismo básico que se sigue muy frecuentemente en la investigación, es:

Si H es cierta en condiciones de Diseño D, y bajo supuestos adicionales SA, se espera que ocurra E. Donde E es básicamente una especificación o predicción de la forma esperada, en que debe cambiar la distribución de la Y, al considerar los diversos cambios en X. Esta es una consideración puramente deductiva. Se va a contrastar (comparar) con la información empírica que se obtenga al llevar a cabo el estudio con el diseño D, y observar un resultado O, para considerar en que medida se obtiene lo esperado que es E. Se tiene así el esquema:

La conclusión se lleva a cabo, al evaluar la comparacion, contrastacion, de la teoría con la práctica. De manera general se tiene, si hay concordancia entre esperado E y lo que ocurre O, se apoya la H (hipótesis). Este apoyo no implica que sea verdadera. En caso contrario, si hay discrepancias, es decir lo que ocurre en la práctica, O esta muy discordante con E, entonces se rechaza la H. Esto es el llamado falsacionismo de Popper. Sin embargo es importante resaltar dos aspectos del proceso. Primero que se rechaza o apoya la hipótesis en forma condicionada a la operación de los supuestos adicionales, SA y la validez del diseño D. Se suspende entonces una conclusión definitiva. Por otro lado la forma de valorar el grado de concordancia entre lo esperado teoricamente E, y lo que realmente ocurre O, depende de aspectos subjetivos y de consideraciones teóricas incluidas en los SA. Es frecuente el uso de la estadística, con su modelación matemática, para valorar la magnitud de la discrepancia entre O y E. De modo intuitivo, si la discrepancia es “grande”, se rechaza H, en caso contrario no se rechaza. R. A. Fisher utilizó la modelacion de la aleatoriedad en el proceso y encuentra la probabilidad de que si H es cierta ocurra una discrepancia como la obtenida entre O y E , o mayor, lo que se conoce en estadística como el valor de P (P aquí en el sentido de probabilidad). Entonces se establece una equivalencia: La discrepancia entre O y E se considera “grande” si su valor de P es “pequeño”. El propio Fisher propuso como valor de P pequeño 0.05 o 0.01, y es denominado “nivel de significancia” . Al proceso se le llama “Prueba de Significancia Estadística”

Es importante resaltar que el razonamiento : “si la discrepancia entre E y O es grande se rechaza la H”, es muy general y no se restringe a consideraciones estadísticas; los humanos lo usan en inumerables ocasiones,. En caso de fenómenos con gran variabilidad o aleatoriedad, es muy frecuente el uso de las pruebas de significancia.

En el razonamiento anterior es de suma importancia reconocer que siempre existe la posibilidad de “Explicaciones Alternativas”

Donde A, B, ...Q son explicaciones alternativas a H (niegan H), cada una con sus supuestos adicionales SAA SAB ... SAQ y que con el mismo diseño también implican la ocurrencia de E

En este caso si ocurre O muy cercano o igual a E, se apoyan tanto H, como A, B,... Q. Si hay mucha discordancia entre O y E, se rechaza la H y se rechazan también todas las explicaciones alternativas y H.

En este situación, si ocurre una gran concordancia entre O y E, se apoya por igual H y las explicaciones alternativas A, B, ...Q. Lo que se debe evaluar en base a información empírica y teórica, es la válidez o plausibilidad de los SAA ,SAB... SAQ . Si se tiene alguna explicación alternativa con un supuesto plausible y probable, el diseño es inadecuado. Se recomienda cambiar el diseño para hacer que ahora ya no sea posible o por lo menos que sea improbable esa explicación alternativa.

De nuevo, este planteamiento es general y es muy frecuente como un tipo de razonamiento en la investigación en áreas fácticas. En el caso de una hipótesis H en términos de causalidad probabilística, que establece como E un cambio en la forma de distribución de una o más variables, una explicación alternativa que se considera rutinariamente es el azar, es decir la explicación de por que O es igual casi a E sin que sea cierta H, se atribuye a la aleatoriedad del fenómeno

Otras fuentes importantes de explicaciones alternativas surgen de los llamados factores de confusión, que son factores asociados con los factores causales, pero que tambien pueden provocar el cambio E, en los efectos. El ejemplo clasico es “ si planteamos en H , que hay un factor, vg. Fumar, que causa cancer pulmonar, entonces E es que esperamos que en un grupo de fumadores se tenga mayor proporción de cancer que en un grupo de no fumadores. Sin embargo si en el primer grupo predominan los jovenes y en el segundo las personas de edad avanzada, si se observa O cercano a E, entonces realmente no se sabe si esta cercania ocurrió por el fumar o por la edad. La edad es un explicación alternativa a la H el fumar en la causalidad del cancer pulmonar. Un cambio de diseño es buscar personas de “la misma” edad. O bien que la distribución de las edades en ambos grupos sea la misma. Otra forma de “eliminar” o tomar en cuanta esos factores de confusión es mediante la modelación de sus efectos en forma conjunta con los factores causales; se tienen así los llamados efectos “corregidos”. Simplificando el planteamiento, usualmente se denomina con variable X a los cambios en los posibles factores causales (v. independiente) y como Y a la variable (dependiente) la que mide los resultados observados, la O. La estrategia de diseño, de análisis, o ambos es buscar una relación entre la X y la Y, que no desaparece al condicionar (mantener constante) otros factores A, B, ... Q. que pueden ser explicaciones alternativas. Este condicionamiento se logra por diseño o por análisis. Se dice X se asocia con Y dados A, B, ...Q.

Para ilustrar los aspectos metodológicos y epistémicos que se encuentran en la búsqueda de relaciones e causalidad probabilística, planteo a mis alumnos la siguiente aseveración y ellos deben señalar si la consideran falsa o verdadera: -“En un estudio sobre el ejercicio físico y ácidos grasos, se tenia un grupo de 100 personas que realizó ejercicio físico vigoroso durante un año, y un grupo control también de 100 personas fue sedentario. El grupo de ejercicio tuvo un promedio de ácidos grasos de 12.3 mg por 100 cc. en suero, y el promedio para el de sedentarios fue de 17.5 ; se realiza una prueba de t y resulta muy significativa (p< 0.0001). Se concluye el ejercicio físico vigoroso disminuye los ácidos grasos en suero”-. Frecuentemente la respuesta es que es verdadera. Esto se debe quizá a un exceso de confianza y probablemente no entender lo que es una prueba de significancia estadística, además de ignorar el diseño. Si los que hacen ejercicio son jóvenes y los que no lo hacen, son viejos, las diferencias se pueden deber a la edad y no al ejercicio, aun que sean significativas las diferencias. Otras explicaciones alternativas ocurren por ejemplo por errores de medición, si los que realizan ejercicio se les toma la muestra de sangre y transcurren 2 horas para su análisis y en cambio a los sedentarios se les hace la determinación en 20 minutos, puede haber una degradación de los ácidos grasos y resultar menor en los de ejercicio que en los otros, pero no por efecto del ejercicio. Para apoyar una relación de causalidad se requiere el aspecto empírico de la estadística, además de tener un diseño que elimine en la medida de lo posible explicaciones alternativas a la hipótesis de causalidad, también un apoyo de teorías aceptadas. Un error muy frecuente de algunos usuarios de la estadística es el de concluir sobre relaciones causales ante una relación entre variables que es significativa estadísticamente. Para la interpretación de la significancia estadística es necesario conceptualizar que los sujetos con y sin ejercicio son muestras de sendas poblaciones y que lo que interesa es comparar las medias de los valores de ácidos grasos en las poblaciones. Así se denota por µ1 la media de ácidos grasos de toda una población infinita o muy grande de sujetos parecidos a los del estudio en raza, edad, etc. Que realiza ejercicio y µ2 la de otra población de sujetos iguales que no realizan el ejercicio. La prueba de significancia lo que señala es que bajo el supuesto de que µ1=µ2 , se espera que los promedios de ambas muestras sean iguales (E, esperado) ocurre una discrepancia de 17.5 – 12.3 =5.2 (O), y es muy improbable (menor a 0.0001, es decir menos de 0.01%) de tener una discrepancia como la obtenida o mayor. En base a esto, lo único que se puede afirmar con muy poco error es que no es cierto que µ1=µ2 pero de ninguna manera a que se debe la diferencia entre µ1y µ2.

Al esfuerzo de eliminar explicaciones alternativas (en particular factores de confusión) a una hipótesis de causalidad probabilística se le ha llamado Validez Interna El término designa que el estudio de manera interna es valido para que se pueda interpretar como un apoyo a la hipótesis de causalidad probabilística.

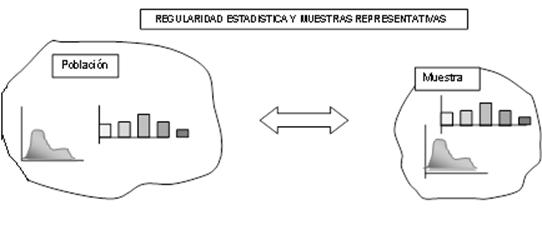

7.1 Validez Externa Una característica de los razonamientos estadísticos es la referente a que se pretende obtener conclusiones sobre un universo o población a partir de una muestra. Esto se puede extender a varias poblaciones a partir de varias muestras. Para que esto sea válido, se requiere que la muestra sea representativa de la población. Por representativo se entiende que los aspectos importantes para el estudio se reproduzcan en la muestra de manera semejante a los de la población. Esta definición es dependiente de los propósitos de la investigación, lo cual la hace sujeta a consideraciones subjetivas. Así por ejemplo una muestra formada con los 45 alumnos de un curso de filosofía puede ser representativa de todos los alumnos de una universidad (la población) si se estudian los niveles de colesterol o las presiones arteriales de la población, pero no lo es si se estudia el conocimiento de la población respecto a la epistemología.

La distribución de las variables de interés en la muestra y en la población es semejante.

El aspecto básico para la representatividad queda expresado por la llamada “ley de los grandes números” (J. Bernoulli 1713, Ars. Conjectandi),:Si la muestra se toma en forma aleatoria, cualquier elemento de la población tiene la misma probabilidad de ocurrir en la muestra, y además el tamaño de la muestra es “grande”, entonces las proporciones en la muestra se parecen a las de la población.

Si

la muestra se toma “al azar”, la proporción de la

muestra se acerca cada vez más a la de la población

limn→∞

P = p.

Esto hace que si la proporción se refiere a cualquier

intervalo de valores, la proporción en la muestra se acerca la

de la población; si esto se considera simultáneamente

para varios intervalos de valores, toda la distribución en la

muestra se acerca a la poblacional. En algunas aplicaciones de la

estadística, las llamadas de “Muestreo” se toman

las muestras aleatorias de las poblaciones para que resulten

representativas, o bien se hacen ajustes matemáticos para

lograr la representatividad.

Sin embargo hay muchas situaciones

de investigación en biología, medicina, y otras

disciplinas en las que es común tener una muestra que no se

toma aleatoriamente de la población, esto se hace por razones

de accesibilidad o economía, por ejemplo los alumnos de un

grupo, los voluntarios que responden, o los pacientes que acuden a un

hospital. En este caso se define una población para la cual la

muestra es representativa. Esta población se define a partir

de la distribución en la muestra de aquellas características

importantes para la investigación.

Referencias Bibliográficas

Lakoff G. y Johnson, M. (1999). “ Philosofhy in the flesh. The emboided mind and its challenge to western thouht ”. New York : Basic Book.